Skalierbare KI/ML-Infrastrukturen

79,90 €

Derzeit nicht verfügbar

- Kubernetes- und OpenShift-Cluster mit NVIDIA-GPUs

- Skalierbare und resiliente Infrastrukturen in der Cloud oder On-Prem

- Vollautomation mit IaC und Operatoren

Produktinformationen "Skalierbare KI/ML-Infrastrukturen"

Evaluieren, Automatisieren, Praxis

Moderne KI/ML-Modelle brauchen leistungsstarke Infrastrukturen. Wie Sie abseits der Hypes resiliente, hochautomatisierte und autoskalierbare Systeme für Produktiv-Workloads aufbauen, zeigt Ihnen Oliver Liebel in diesem Wegweiser. Sie erfahren, wie Sie NVIDIAs Datacenter-GPUs nahtlos in Hypervisoren und moderne Container-Infrastrukturen integrieren, sie Operator-gestützt mit Kubernetes bzw. OpenShift verwalten und daraus praxistaugliche Setups machen, die im Unternehmenseinsatz und echten Business Cases bestehen.

Betrachtet wird der ganze Infrastruktur-Stack, mit Fokus auf effizienter Vollautomation: Von On-Premises-Installationen auf vSphere oder Cloud-Setups auf GCP und AWS über Plattform-Automation per IaaS/IaC sowie den GPU- und Network-Operatoren bis hin zu einem Ausblick auf AI End-to-End-Tool-Stacks.

Aus dem Inhalt:

- KI/ML: Grundlagen und Use Cases

- Infrastruktur planen: On-Premises, Cloud oder Hybrid?

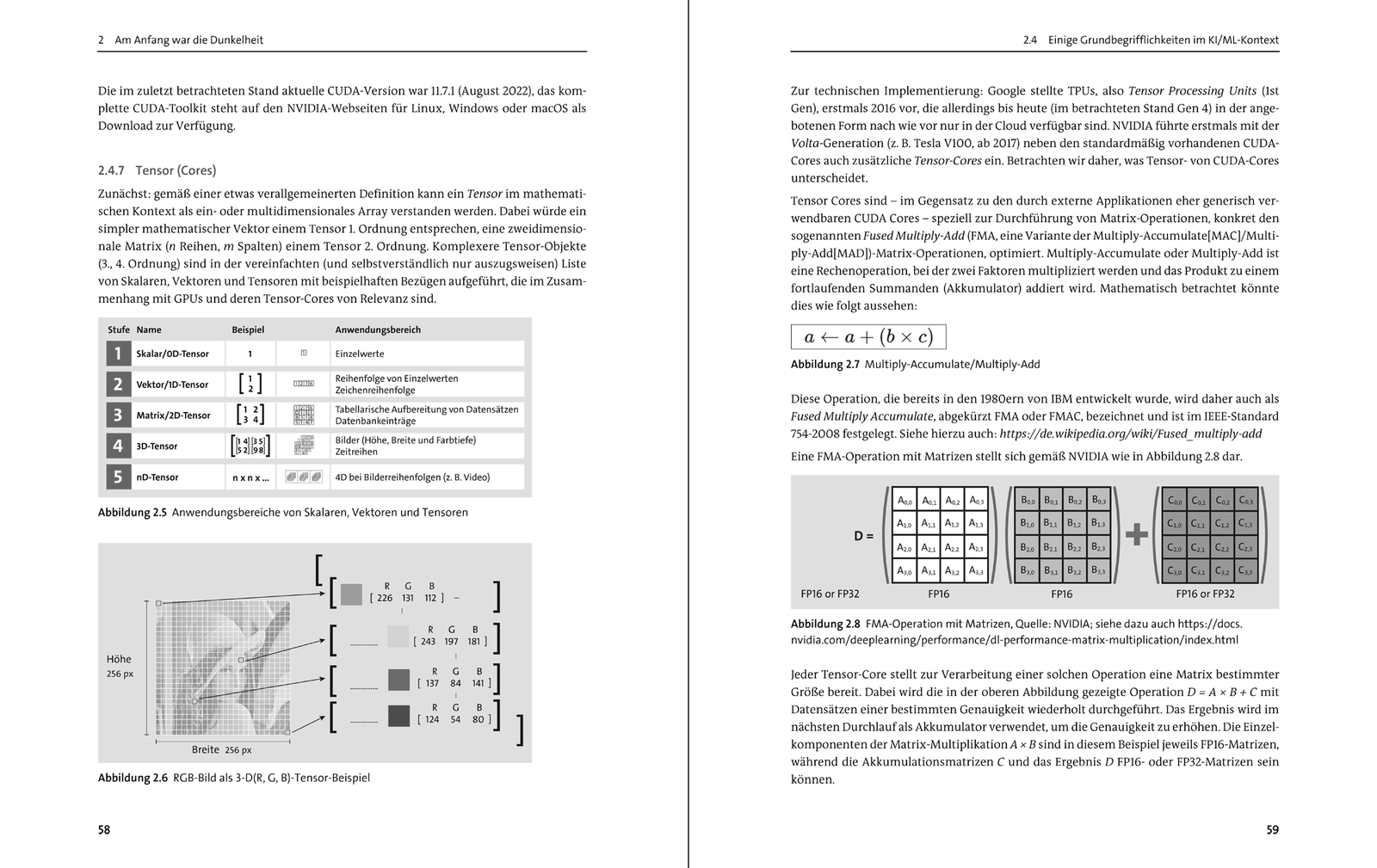

- Technischer Background: KI/ML mit NVIDIA-GPUs

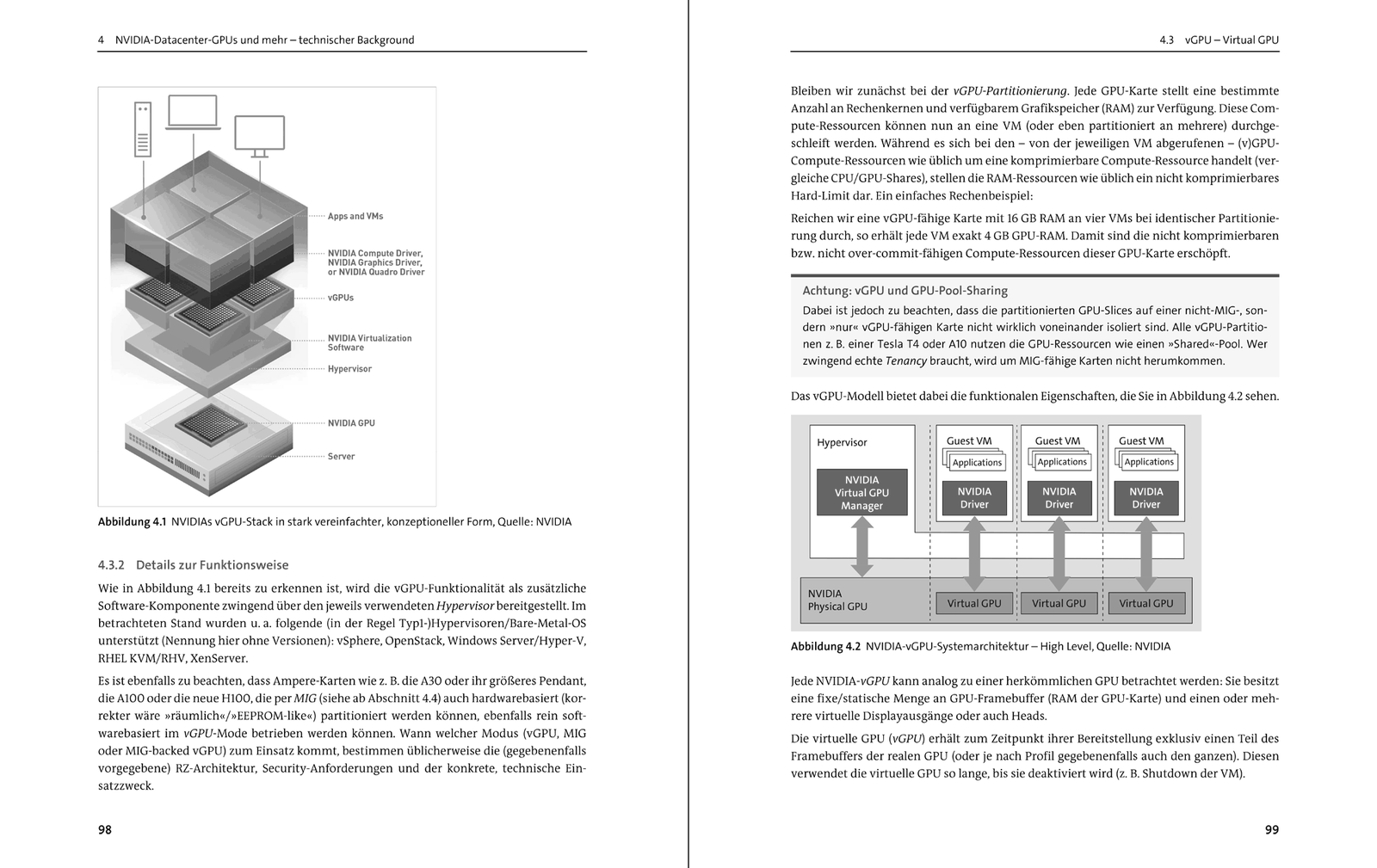

- GPU-Modi: Passthrough-MIG vs. MIG-backed vGPU vs. vGPU

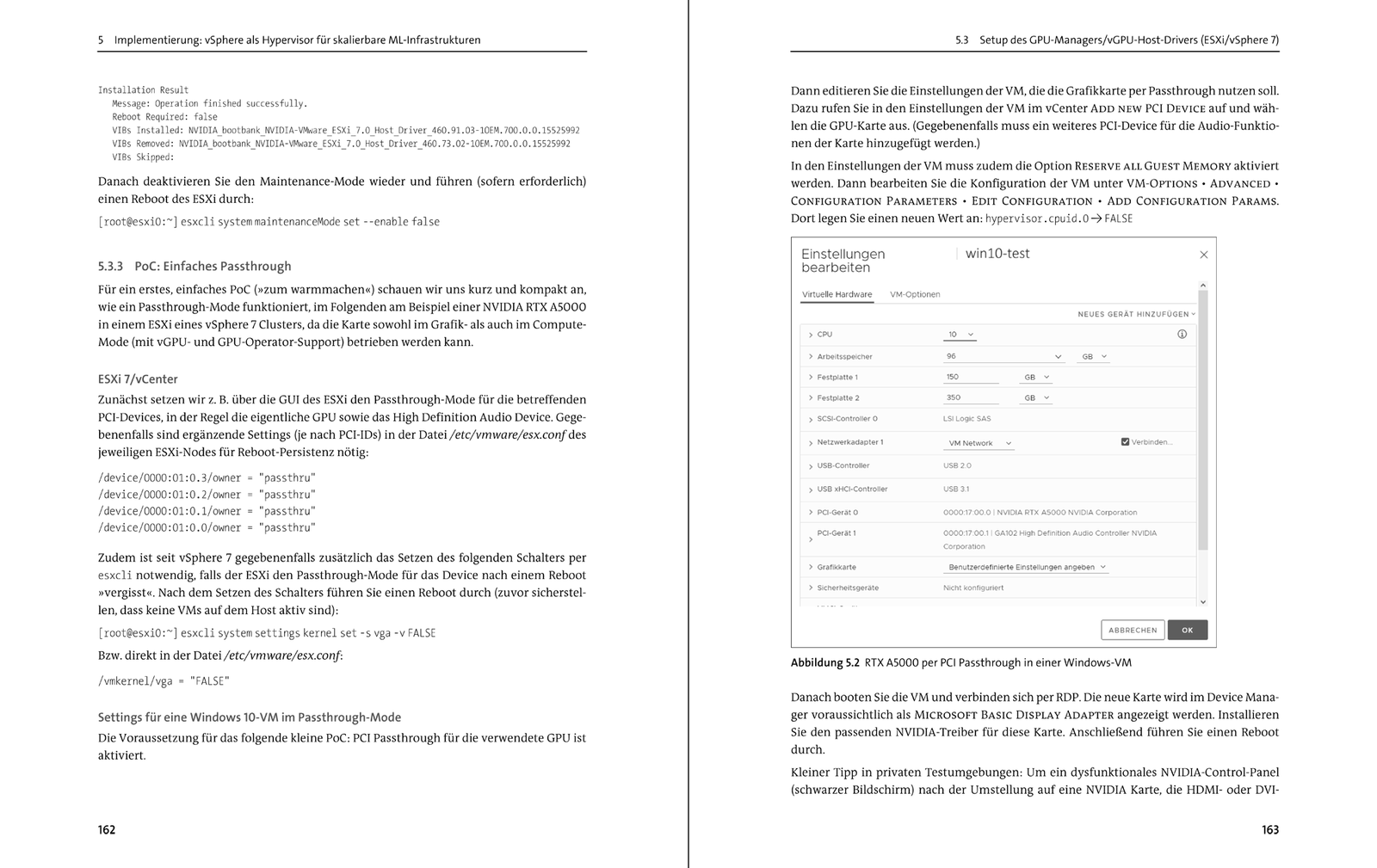

- NVIDIA-GPUs auf vSphere On-Prem implementieren

- NVIDIA AI Enterprise

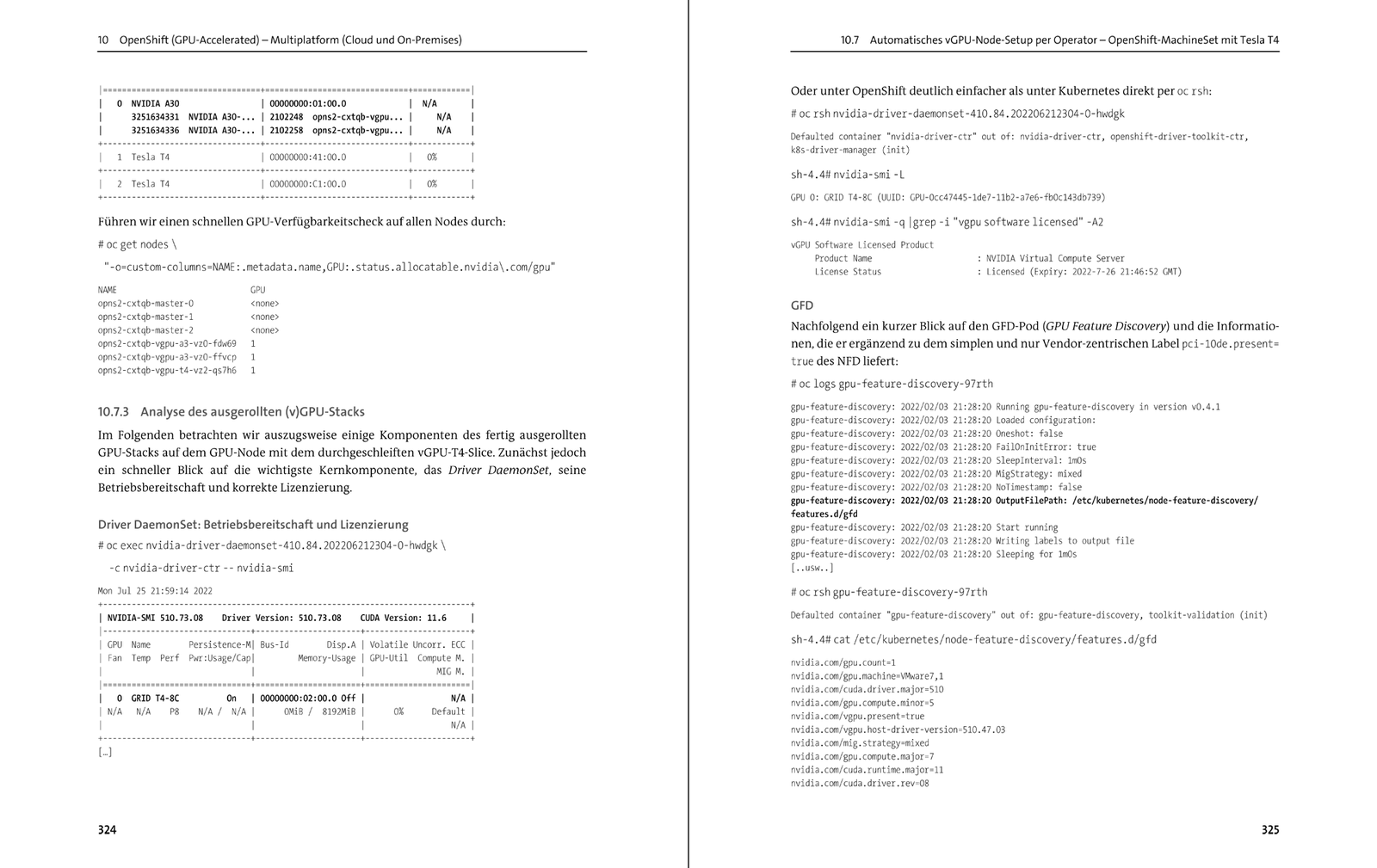

- KI/ML-Cluster mit Kubernetes und OpenShift

- GPU-spezifische Operatoren

- GPU-Cluster mit OpenShift

- Von CI/CD über GitOps zu MLOps

- ML-Pipelines & AI End-to-End

Autor:

Dipl.-Ing. Oliver Liebel ist LPI-zertifizierter Linux-Enterprise-Experte, Partner von Red Hat und SUSE und steht in engem Kontakt mit NVIDIAs EGX-Abteilung.

Artikel-Details

- Anbieter:

- Rheinwerk Verlag

- Autor:

- Oliver Liebel

- Artikelnummer:

- 9783836273930

- Veröffentlicht:

- 05.01.23

- Seitenanzahl:

- 468